Пер. с англ. Глеба Голубкова и Петра Строкина

Опубликовано в журнале НЛО, номер 4, 2019

Перевод Петр Строкин, Глеб Голубков

Маттео Пасквинелли (Университет искусств и дизайна, Карлсруэ, профессор; PhD)

Matteo Pasquinelli (University of Arts and Design, Karlsruhe, professor; PhD) mail@matteopasquinelli.org

Ключевые слова: искусственный интеллект, нейронные сети, автоматизация интеллекта, перцептрон, абдукция

Key words: artificial intelligence, neural networks, automation of intelligence, perceptron, abduction

УДК/UDC: 004.89+130.2

Аннотация: В статье делается акцент на роли логических вентилей в распределенной архитектуре нейронных сетей, в которых обобщенный контур управления влияет на каждый узел вычисления, производимого для распознавания паттернов. В этой распределенной и адаптирующейся архитектуре логических вентилей информация сама превращается в логику, а не обрабатывается ею сверху вниз; то есть репрезентация мира становится новой функцией в описании того же мира.

Abstract: The text highlights the role of logic gates in the distributed architecture of neural networks, in which a generalized control loop affects each node of computation to perform pattern recognition. In this distributed and adaptive architecture of logic gates, rather than applying logic to information top-down, information turns into logic, that is, a representation of the world becomes a new function in the same world description.

Перцептроны [искусственные нейронные сети] не предназначены служить точной копией какой-либо конкретной нервной системы. Они представляют собой упрощенные сети, созданные для изучения закономерных взаимосвязей между организацией нервной сети, структурой окружающей ее среды и «психологическими» свойствами, которыми может обладать данная сеть. Перцептроны могут соответствовать конкретным частям больших сетей в биологических системах… Чаще всего, однако, они представляют собой предельно упрощенную модель центральной нервной систем. Это приводит к тому, что одни свойства оказываются гипертрофированными, другие — подавленными.

[Розенблатт 1965: 41].

Как не существует алгоритма для метафоры, так и метафора не может быть создана посредством точных инструкций компьютера; и неважно, какой объем организованной информации ему предоставлен.

[Eco 1986: 127].

Термин «искусственный интеллект» часто упоминается в широкой прессе, а также среди философов и людей, связанных с искусством, он используется как некий алхимический талисман, функционирование которого редко объясняется. Доминирующая сегодня парадигма (также важная для автоматизации труда) зиждется не на символическом искусственном интеллекте (Good Old—Fashioned Artificial Intelligence) (который так и не преуспел в автоматизации символической дедукции), а на нейронных сетях, разработанных Фрэнком Розенблаттом еще в 1958 году для автоматизации статистической индукции. В этом тексте главное внимание уделяется роли логических вентилей (logic gates) в распределенной архитектуре нейронных сетей, в которых обобщенный контур управления влияет на каждый узел вычисления, производимого для распознавания паттернов. В этой распределенной и адаптирующейся архитектуре логических вентилей информация сама превращается в логику, а не обрабатывается ею сверху вниз; то есть репрезентация мира становится новой функцией в описании того же мира. Эта базовая формулировка предлагается как более точное описание процесса обучения, бросающее вызов идеалистическому определению (искусственного) интеллекта. Если распознавание паттернов посредством статистической индукции является наиболее точным описанием того, что принято называть искусственным интеллектом, искажающие эффекты статистической индукции, влияющие на коллективное восприятие, интеллект и управление (переобучение, апофения, алгоритмическое смещение, «глубокое сновидение» и т. д.), еще предстоит полностью изучить.

В общем и целом, в этом тексте выдвигается гипотеза, согласно которой новые машины обогащают и дестабилизируют математические и логические категории, на базе которых они были разработаны. Любая машина всегда является машиной познания, продуктом человеческого интеллекта и неуправляемой составляющей механизмов расширенного познания (extended cognition). Благодаря машинам человеческий интеллект достигает новых логических горизонтов в материалистическом смысле: то есть благодаря историческим артефактам, а не идеализму. Например, тепловой двигатель повлек за собой появление термодинамики как науки (а не наоборот); компьютеры, в свою очередь, возможно, помогут пролить свет на проблемы философии сознания и логики. Когда Алан Тьюринг выдвинул идею универсальной вычислительной машины, его задачей была простейшая машинная операция (machination) для расчета всех возможных функций. Эффективность универсального компьютера вдохновила Тьюринга на алхимический проект автоматизации человеческого интеллекта. Однако все это могло оказаться милым парадоксом, показывающим, как машина Тьюринга, рожденная в рамках Gedankenexperiment, демонстрирует неполноту математики, стремящейся описать исчерпывающую парадигму интеллекта (как обычно понимают тест Тьюринга).

Единица информации — это логическая единица решения

Вместо обсуждения символического искусственного интеллекта — дедуктивного (top-down) применения логики к информации, полученной из внешнего мира, — этот текст пытается проследить превращение внешней информации во внутреннюю логику в результате машинных операций нейронных сетей. В нейронных сетях (в соответствии с классической кибернетикой) информация становится контролем; то есть числовые входные данные, полученные из мира, реализуют функцию контроля в отношении этого же мира. Говоря философски, это значит, что репрезентация мира (информация) становится новым правилом в этом же мире (функцией), но с известной степенью статистической погрешности. «Информация становится логикой» — это очень грубое описание интеллекта, которое, однако, призвано подчеркнуть открытость миру как непрекращающемуся процессу обучения.

Превращение информации в функцию более высокого порядка можно заметить на разных этапах развития разумных машин: этот текст подчеркивает лишь раннее определение информации и петли обратной связи, прежде чем переходит к анализу их развития в нейронных сетях. Превращение информационного узла в более высокие формы знания было предметом изучения кибернетики второго порядка на протяжении 1970-х годов, однако уже в конце 1950-х годов нейронные сети Розенблатта демонстрировали тот же процесс [Heylighen, Joslyn 2001]. Чтобы понять, как нейронные сети превращают информацию в логику, стоит деконструировать традиционное отношение к понятиям информации и информационной обратной связи. Обычно Клода Шэннона осуждают за сведение информации к математическому измерению, соответствующему шуму канала передачи [Шэннон 1963]. Интересно, что в тот же период Норберт Винер определил информацию как решение:

Что же представляет собой эта информация и как она измеряется? Одной из простейших, наиболее элементарных форм информации является запись выбора между двумя равновероятными простыми возможностями, одна из которых обязательно должна осуществиться (например, запись выбора между гербом и решеткой при бросании монеты). Мы будем называть решением однократный выбор такого рода [Винер 1958: 82][2].

Если каждый бит информации является единицей решения, в рамках информации найдена атомарная доктрина контроля. Если информация является решением, каждый бит информации — это маленькая составляющая логики контроля. Бейтсон, как известно, добавит: «…информация — это различие, которое имеет значение (a difference that makes a difference)». Тем самым, он готовил кибернетику к более высоким порядкам организации [Бейтсон 2000]. Кибернетика второго порядка разрушила проклятие негативной обратной связи и избавилась от присущей ранней кибернетике одержимости сохранять биологические, технические и социальные системы в постоянном равновесии. Петля негативной обратной связи определяется как информационная петля, которая постепенно адаптируется к окружающей среде (регулируя свою температуру, расходование энергии и т. д.). Петля позитивной обратной связи, в свою очередь, выходит из-под контроля и выводит систему из равновесия. Кибернетика второго порядка заметила, что только системы, далекие от равновесия, способны создавать новые структуры, привычки и идеи (нобелевский лауреат Илья Пригожин показал, что формы самоорганизации появляются также и в турбулентных и хаотических состояниях [Николис, Пригожин 1979]). Хотя уже в основополагающем определении ранней кибернетики петля обратной связи может быть понята как модель превращающейся в логику информации, которая затем сама формирует логику, дабы изобретать новые правила и привычки, лишь кибернетика второго порядка полагает, что именно чрезмерное «давление» внешнего мира заставляет машинную логику мутировать.

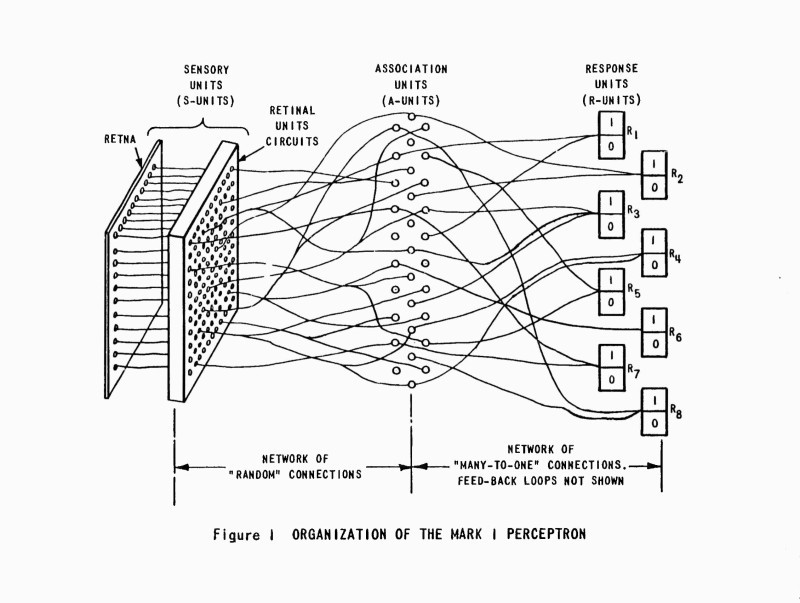

Диаграмма организации «перцептрона Mark I». Источник с петлей обратной связи не показан. Источник: [Rosenblatt 1960]

Фрэнк Розенблатт и изобретение перцептрона

В то время как можно найти множество различных генеалогий эволюции искусственного интеллекта, этот текст повествует лишь о решающей конфронтации двух одноклассников из Старшей научной школы Бронкса: Марвина Мински, основателя лаборатории искусственного интеллекта в Массачусетском технологическом институте, и Фрэнка Розенблатта, создателя первой оперативной нейронной сети, перцептрона. Столкновение Мински и Розенблатта зачастую упрощают и представляют как спор между дедуктивной парадигмой, основанной на правилах (символический искусственный интеллект), и распределенным параллельным вычислением (коннективизм). Во второй модели полностью разумный алгоритм не реализован в начале работы системы: машина обучается в процессе взаимодействия с окружающей средой и постепенно становится «разумной». Выражаясь логически, речь идет о противостоянии символической дедукции и статистической индукции[3].

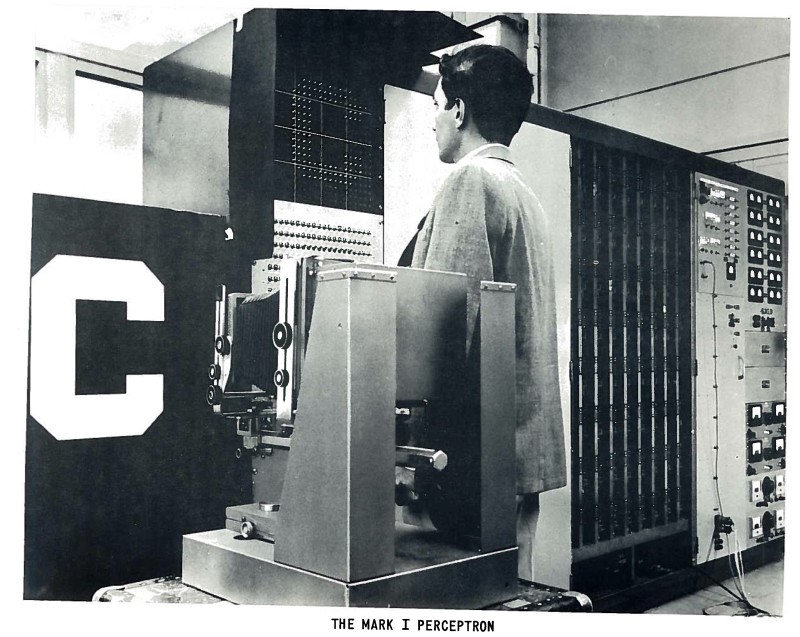

В 1951 году Мински создал первую искусственную нейронную сеть SNARC (решающую комплексные задачи), но затем оставил этот проект, будучи уверенным, что нейронные сети потребуют чрезмерно много вычислительных мощностей [Minsky 1954]. В 1957 году Розенблатт описал первую успешную нейронную сеть в докладе для Корнельской воздухоплавательной лаборатории, который был назван «Перцептрон: автомат восприятия и распознавания». Как и Мински, Розенблатт кратко представил свою нейронную сеть, предлагая индуктивную (bottom-up) и распределенную структуру в качестве основы для идеи искусственного нейрона Уоррена Маккаллока и Уолтера Питтса, которая, в свою очередь, была создана под впечатлением от структуры нервных клеток глаза [Маккалок, Питтс 1956; McCulloch, Pitts 1947]. Первая нейронная машина, «Перцептрон Mark I» в действительности была машиной зрения[4].

Первичное требование к такой системе — способность распознавать сложные паттерны информации, схожие на феноменальном уровне… процесс, который соответствует психологическим феноменам ассоциации и «обобщению стимула». Система должна распознавать одинаковые объекты с различных ракурсов, с разными размерами, цветами, преобразованиями, которые представлены на различных фонах. Она должна быть способна конструировать электронную или электромеханическую систему, которая научится распознавать сходства и тождества между паттернами оптической, электронной или тональной информации, аналогично процессам восприятия биологического мозга. Работа предложенной системы зависит скорее от вероятностных, нежели от детерминистских, принципов. Система становится надежной благодаря свойствам статистических измерений, полученных из большого объема информационных элементов [Rosenblatt 1957: 1—2].

Необходимо прояснить, что перцептрон был не машиной, распознающей такие простые формы, как, например, буквы (их оптическая идентификация к тому времени уже существовала), но машиной, которая могла бы научиться распознавать формы, высчитывая скорее один статистический файл, нежели сохраняя множество таких файлов в своей памяти. Выходя за пределы проблемы распознавания образа (image), Розенблатт пророчески добавил:

…от устройства такого типа в конечном счете ожидается способность формировать понятия, переводить с одного языка на другой, сличать военное оборудование и решать задачи с помощью индуктивной логики [Rosenblatt 1957: 30].

В 1961 году Розенблатт опубликовал работу «Принципы нейродинамики: перцептроны и теория механизмов мозга», которая окажется влиятельной и для сегодняшних нейронных вычислений (например, термин «многослойный перцептрон» уже встречается в данной работе). Изложение в книге начинается с психологических и нейрологических находок, касающихся нейропластичности, и автор применяет их к разработке нейронных сетей. Перцептрон был искусственной моделью мозга, которая была призвана объяснить некоторые его механизмы, при этом не являясь его точной копией. (На самом деле нейронные сети задумывались как имитация глазных, а не мозговых нейронов, хотя и без учета того, как зрительная кора обрабатывает визуальные входные данные.) Розенблатт подчеркивал, что искусственные нейронные сети являются и упрощением, и преувеличением относительно нервных систем и эта приблизительность (то есть признание пределов базирующегося на модели мышления) должно направлять философию (искусственного (artefactual)) разума. В конечном счете, Розенблатт противопоставил нейродинамику как дисциплину шумихе вокруг искусственного интеллекта.

Программа по исследованию перцептрона связана главным образом не с изобретением устройств, обладающих «искусственным интеллектом», а с изучением физических структур и нейродинамических принципов, которые лежат в основе «естественного интеллекта». Перцептрон является, прежде всего, и главным образом моделью мозга, а не устройством для распознавания образов (pattern). Его использование в качестве модели мозга позволяет определить физические условия образования различных психологических свойств. Он ни в коей мере не является «полной» моделью, и мы ясно сознаем упрощения по сравнению с биологическими системами, однако принятая модель, по крайней мере, поддается анализу [Розенблатт 1965: 18; перевод изменен].

В 1969 году Марвин Мински и Сеймур Паперт в книге под названием «Перцептроны» критиковали предложенную Розенблаттом модель нейронной сети, ошибочно полагая, что перцептрон (хотя и простой, однослойный перцептрон) не может изучить функцию ИЛИ (XOR) и классифицировать большое количество измерений. Эта строптивая книга произвела огромный эффект (в том числе из-за преждевременной смерти Розенблатта в 1971 году) и заблокировала финансирование исследования нейронных сетей на десятилетия. То, что принято называть первой «Зимой искусственное интеллекта», лучше описывать как «зиму нейронных сетей», продлившуюся вплоть до 1986 года, когда в двухтомнике «Параллельная распределенная обработка» было показано, что (многослойные) перцептроны в действительности способны к освоению сложных логических функций [Rumelhart, PDP Research Group 1986]. Полвека и множество нейронов спустя, при всем уважении к Мински, Паперту и другим фундаменталистам символического искусственного интеллекта, многослойные перцептроны оказались способны распознавать изображения лучше человека. Они составляют основу для систем глубокого обучения, таких как автоматический перевод или самоуправляемые машины[5].

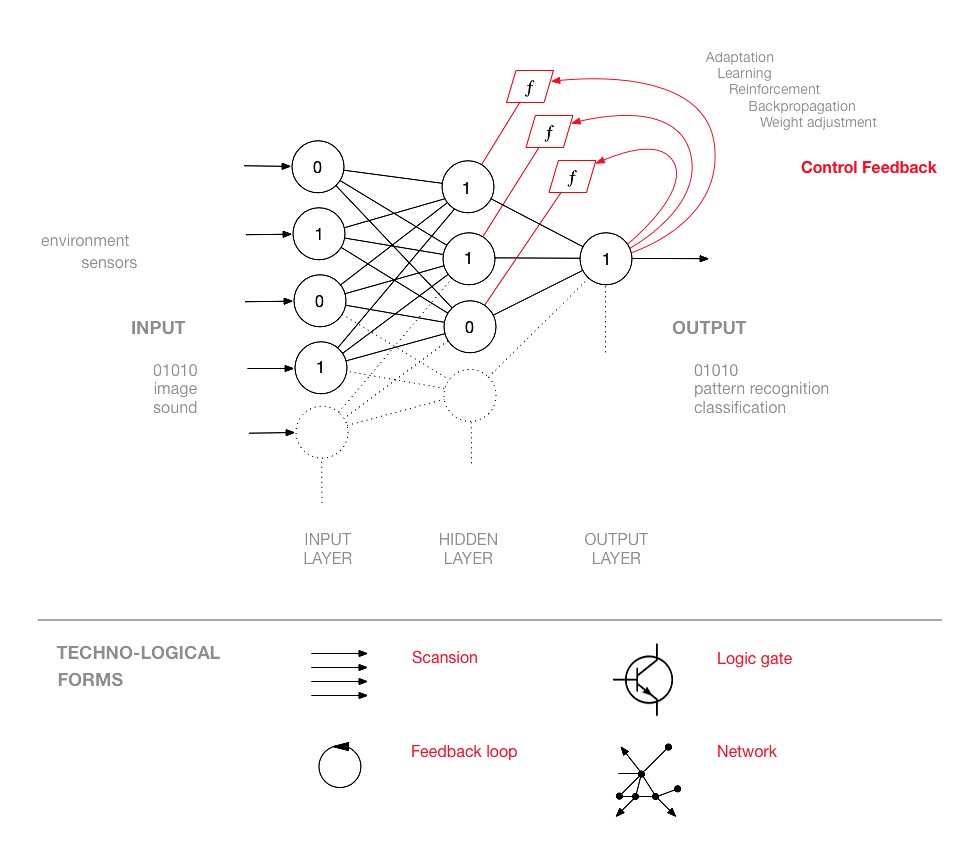

Диаграмма простой нейронной сети, на которой представлены петли обратной связи. Маттео Пасквинелли, HfG Карлсруэ. Источник: www.academia.edu/33205589

Анатомия нейронной сети

Изобретение нейронной сети можно описать в терминах археологии медиа как композицию четырех техно-логических форм: сканирование (дискретизация или дигитализация аналоговых входных данных), логический вентиль (который может быть представлен потенциометром, клапаном, транзистором и т.д.), петля обратной связи (основная идея кибернетики) и сеть (вдохновленная организацией нейронов и синапсов). Тем не менее задачей нейронной сети является вычисление статистико-топологической конструкции, более сложной, чем размещение обозначенных форм. Функцией нейронной сети является протоколирование схожих входных паттернов (массив данных для тренировки сети) в качестве внутреннего состояния ее узлов. Как только внутреннее состояние вычислено (т. е. нейронная сеть «обучена» распознаванию определенного паттерна), эта статистическая конструкция может быть установлена в другие нейронные сети с идентичной структурой, а затем использована для распознавания паттернов среди новых данных

Хотя логические вентили обычно входят в состав линейных структур вычислений, в параллельных вычислениях нейронных сетей они приобретают новые свойства. В этом смысле Розенблатт, возможно, был одним из первых, кто описал машинный интеллект в терминах эмерджентности:

Важно отметить, что еще никому не удалось обнаружить в отдельных клетках нервной сети какую-либо специфическую психологическую функцию, такую как «память», «самосознание» или «разум». Это дает основания предполагать, что такие свойства присущи не отдельным элементам, а связаны с организацией и функционированием нервной сети в целом [Розенблатт 1965: 27].

При этом нейронные сети являются не горизонтальными, а организованными иерархически посредством слоев. Нейронная сеть состоит из трех типов слоев нейронов: входной, скрытый (их может быть много; отсюда термин «глубокое обучение») и выходной слой. Со времен первого перцептрона (что говорит нечто о значимости визуальной парадигмы) входной слой часто называют сетчаткой, даже если он не вычисляет визуальные данные. Нейроны первого слоя соединены с нейронами следующего, проходя по потоку информации, в котором сложные входные данные кодируются в соответствии с выходными данными, с которыми мы имеем дело. Возникающая структура не является сетью (или ризомой) в полном смысле, но ее скорее можно назвать древовидной сетью, растущей как иерархичный конус, в котором информация переводится в более высокие формы абстракции [Alpaydin 2014: 260]. Каждый нейрон в сети выполняет роль узла-передатчика, но при этом он является и вычислительным узлом. Он является информационным и логическим вентилем. Следовательно, у каждого узла есть две роли: передавать информацию и применять логику. Нейронная сеть «обучается» в том случае, если неверные выходные данные перенаправляются, дабы исправлять ошибки в каждом узле вычислений, пока не будут получены желаемые данные на выходе. Нейронные системы намного сложнее, чем традиционные кибернетические, поскольку в них работает обобщенная петля обратной связи, влияющая на множество узлов вычисления. В этом смысле нейронная сеть является вычислительной архитектурой, разработанной для машинного обучения, которая лучше всего реализует функцию адаптации.

Обобщенная петля обратной связи влияет на функцию каждого узла или нейрона, то есть на способ вычисления узла (его «вес»). Обратная связь, которая контролирует вычисления каждого узла (этот процесс называют согласованием «веса», обратным распространением ошибки (error backpropagation)) может быть уравнением, алгоритмом или даже человеком. В одной конкретной нейронной сети контролирующая обратная связь может, например, изменить ИЛИ-вход на И-вход посредством модификации пороговой величины узла; это значит, что контролирующая обратная связь изменяет ход «мышления» узла[6]. Логические вентили нейронных сетей вычисляют информацию для того, чтобы повлиять на способ вычисления информации в будущем. Именно так информация влияет на логику. Основная задача в крупнейших IT-компаниях с точки зрения бизнеса сегодня — найти самую эффективную формулу нейронной контролирующей обратной связи.

Точнее говоря, нейронные сети учатся распознаванию изображений посредством записи зависимостей или отношений между пикселями, на основании которой производится статистическая выборка для составления внутренней репрезентации. На фотографии яблока, например, красный пиксель может быть окружен другими красными пикселями в восьмидесяти процентах случаев. Таким же образом необычные связи можно комбинировать в более сложные графические атрибуты (грани, линии, изгибы и т. д.). Сеть должна распознавать яблоко с разных углов, и она никогда не запоминает действительное изображение, исключительно его статистические зависимости. Статистический график взаимозависимостей записан ей в качестве многомерной внутренней репрезентации, которая затем ассоциируется с доступным человеку выходом (слово «яблоко»). Такая модель машинного обучения называется обучением с учителем, поскольку человек решает, какие выходные данные являются верными. При обучении без учителя нейронная сеть должна найти в тренировочном массиве данных наиболее часто повторяющиеся паттерны зависимостей, не опираясь на предшествующие классификации (имея массив с изображениями кошек, сеть извлечет характеристики усредненной кошки).

Зависимости и паттерны можно проследить в самых разнообразных типах данных: понять визуальные массивы проще всего, но те же процессы применимы, например, к социальным, медицинским и экономическим данным. Современные техники искусственного интеллекта, очевидно, представляют собой изощренные способы распознавания паттернов, а не интеллект, если понимать его как способность к открытиям и изобретению новых правил. Если быть точным в логических терминах, то, что вычисляют нейронные сети, — это форма статистической индукции. Конечно, такая исключительная форма автоматизированного вывода может быть полезна для реализации творческих и научных способностей (и это наиболее близкое приближение к слабой абдукции Пирса), но она не представляет автоматизацию интеллекта в качестве «изобретения» как таковую, поскольку изобретение остается чем-то «слишком человеческим»[7].

Человеческое, слишком человеческое вычисление

Пирс писал: «…человек есть внешний знак» [Пирс 2000: 92]. Если эта интуиция побуждала философов утверждать, что человеческий разум является искусственным проектом, границы которого задаются технологически, действительное совпадение человеческого разума и внешних ему машин редко подтверждалось эмпирически. Это повлекло за собой ряд упрощающих убеждений, согласно которым такие идеи, как «общий искусственный интеллект» и «суперинтеллект», преподносятся как некие алхимические талисманы постгуманизма с незначительными объяснениями внутренней работы и принципов вычислений. Волнующий момент, связанный с нейронными вычислениями, заключается в том, что они скорее стимулируют развитие категорий человеческого знания, нежели преодолевают их в качестве автономных форм. В противовес наивным концепциям автономии искусственного интеллекта множество элементов в архитектуре нейронных сетей все еще зависят от человеческого вмешательства. Если требуется понять, в какой мере нейронные вычисления «нечеловечны», необходимо оценить, насколько они все еще являются «слишком человеческими». Роль человека (а также локус власти) ясно виден в (1) дизайне массива данных и его категориях, (2) технике исправления ошибок и (3) классификации желаемых выходных данных. Стремясь к краткости, здесь мы затронем только первый аспект.

Дизайн массива данных — самый важный и уязвимый компонент в архитектуре нейронных сетей. Нейронная сеть обучена распознавать паттерны в предшествующих массивах данных с претензией применять эту способность к будущим данным. Как уже неоднократно случалось ранее, если в данных для обучения представлены расовые, гендерные или классовые предрассудки, нейронные сети отразят, усилят и исказят их. Системы распознавания лиц, которые были обучены на массивах с лицами белых людей, были неспособны распознать лица негроидной расы в качестве человеческих. Эту проблему называют «переобучением»: при излишней вычислительной мощности нейронная сеть будет склонна обучаться чрезмерно много, что отразиться в закреплении слишком определенного паттерна. В связи с этим необходимо игнорировать некоторые из результатов вычислений, чтобы распознавательная способность была более гибкой. Схожую проблему можно обнаружить в случае апофении: например, психоделические ландшафты GoogleDeepDream, в которых нейронные сети «видят» несуществующие паттерны или создают паттерны на фоне шума. На примере переобучения и апофении представлены внутренние пределы нейронных вычислений: они показывают, как нейронные сети могут бесконечно вращаться вокруг встроенных паттернов, не обнаруживая новые корреляции.

Проблема переобучения указывает на более фундаментальную проблему, касающуюся учреждения тренировочного массива данных, а именно — на границы категорий, в пределах которых работают нейронные сети. Тот способ, каким массив данных репрезентирует некоторую выборку мира, может обозначить лишь некую закрытую вселенную. Как эта закрытая вселенная данных соотносится с тем, что находится за ее границами? Нейронная сеть «обучена» в том случае, если она способна обобщать свои результаты применительно к неизвестной информации с предельно низкой вероятностью ошибки; такое обобщение, однако, возможно лишь на основе однородности тренировочного и тестового массива данных. От нейронной сети никогда не требуется работать с категориями, не имеющими отношения к ее «образованию». Поэтому возникает вопрос: насколько нейронная сеть (и искусственный интеллект в целом) способна выйти за пределы категориальной онтологии, в которой она работает?[8]

Абдукция неизвестного

Обычно нейронная сеть осуществляет статистическую индукцию на базе однородного массива данных. То есть она экстраполирует паттерны, совместимые со спецификой массива данных (например, визуальный паттерн из визуальных данных). Если же массив неоднороден и содержит многомерные характеристики (в качестве самого простого примера можно привести социальные данные, описывающие возраст, гендер, доход, уровень образования, условия здоровья населения и т. д.), нейронные сети могут обнаружить среди данных такие паттерны, корреляция которых не является чем-то привычным. Даже если нейронные сети показывают недоступные для человеческого разума корреляции, они работают в соответствии с содержащейся в массиве скрытой сеткой (человеческих) постулатов и категорий. Поэтому они не способны осуществить скачок, необходимый для изобретения радикально новых категорий.

«Перцептрон Mark I». Источник: [Rosenblatt 1960]

Введенное Чарльзом Пирсом различие дедукции, индукции и абдукции (гипотезы) лучше всего позволяет очертить границы и возможности машинного интеллекта. Как известно, Пирс заметил, что классические формы логических выводов, дедукция и индукция, никогда не приводят к новым идеям, но лишь повторяют количественные факты. Только посредством абдукции (гипотезы) имеется возможность обогатиться новыми взглядами и изобретением новых правил.

Единственное завоевание индукции заключается в определении ценности количественных величин. Она заручается теорией и измеряет соответствие этой теории фактам. С ее помощью едва ли возможно создать новую идею. Дедукция едва ли способна на большее. Все научные идеи производятся посредством абдукции. Работа абдукции заключается в изучении фактов и разработке теории для их объяснения [Peirce 1965: 145].

В частности, пирсовское различие абдукции и индукции позволит пролить свет на логическую форму нейронных сетей, поскольку с момента их изобретения Розенблаттом они использовались для автоматизации сложных форм индукции.

С помощью индукции мы заключаем, что факты, схожие с уже наблюдаемыми, суть истинны в случаях отсутствия их проверки. Посредством же гипотезы мы выводим существование факта, отличного от когда-либо наблюдаемых, из которого нечто наблюдаемое будет выведено с необходимостью, в соответствии с известными законами. Первая представляет собой переход в рассуждении от частного к общему закону; вторая — от следствия к причине. Первая классифицирует, вторая объясняет [Peirce 1965: 194].

Различие между классифицирующей индукцией и объясняющей абдукцией также очень хорошо очерчивает природу результатов нейронных сетей (и ключевую проблему искусственного интеллекта). Осуществляемая нейронными сетями сложная статистическая индукция приближается к форме слабой абдукции, где новые категории и идеи неясно вырисовываются на горизонте. Но оказывается, что изобретательность и креативность далеки от полной автоматизации. Изобретение новых правил (приемлемое определение интеллекта) заключается не в генерализации конкретного правила (как это происходит в случаях индукции и слабой абдукции), но в прорыве к семиотическим плоскостям, которые прежде были бессвязными или немыслимыми, что имеет место в случаях научных открытий или создания метафор (сильная абдукция).

Умберто Эко в своей критике искусственного интеллекта заметил:

Как не существует алгоритма для метафоры, так и метафора не может быть создана посредством точных инструкций компьютера; и неважно, какой объем организованной информации ему предоставлен [Eco 1986: 127].

Эко подчеркивал, что алгоритмы не способны выбраться из смирительной рубашки категорий, скрыто или явно воплощенных посредством «организованной информации» массива данных. Изобрести новую метафору — значит осуществить скачок и соединить категории, которые никогда прежде логически не соотносились. Нарушить лингвистическое правило — значит изобрести новое, однако только в том случае, когда нарушение охватывает создание более сложного порядка, относительно которого старые правила оказываются упрощенными и примитивными. Нейронные сети могут вычислять метафоры a posteriori[9], но с их помощью не выйдет автоматизировать изобретение новых метафор a priori (не учитывая комичные результаты, такие как генерирование случайного текста). Автоматизация (сильной) абдукции остается философским камнем искусственного интеллекта.

(Квази)объяснимый искусственный интеллект

Текущие дебаты вокруг искусственного интеллекта сводятся к обсуждению эпистемологических травм, вызванных подъемом нейронных вычислений. Утверждается, что машинный интеллект открывает новые перспективы знания, которые необходимо распознать как подведомственные постчеловеческому (см. идею Лиотара о нечеловеческом (inhuman)). При этом мало внимания уделяется символическим формам распознавания паттернов, статистических выводов и слабой абдукции, которые составляют этот постчеловеческий сдвиг. Также утверждается, что новые масштабы вычисления вместе оказываются неким черным ящиком, выходящим за пределы способностей человеческого (и политического) контроля; такие утверждения, однако, не учитывают, что в отношении архитектуры такого черного ящика можно произвести реинжиниринг. Последующие абзацы подчеркивают, что человек все еще может достичь «нечеловеческой» бездны глубокого вычисления и что человеческое влияние все же распознаваемо в львиной доле «нечеловеческих» результатов вычислений.

Нескончаемые слои искусственных нейронов действительно предполагают так много вычислений, что проблематично оглянуться на такую структуру и выяснить, где и как было просчитано конкретное «решение». Искусственные нейронные сети принято рассматривать как черные ящики, поскольку они едва ли (или вообще не) способны объяснять каузальность или значимость тех или иных характеристик для производства вывода (например, классификации). Программист часто не имеет контроля над извлекаемыми характеристиками, поскольку они высчитываются нейронной сетью самостоятельно[10].

Как это зачастую и бывает, эта проблема хорошо известна военным. DARPA (Управление перспективных исследовательских проектов Министерства обороны США) ищет решения проблемы черного ящика в рамках программы «Объяснимый искусственный интеллект» (Explainable Artificial Intelligence (XAI))[11]. Одной из исследуемых проблем, например, является создание самоуправляемого танка, способного разворачиваться в необычных направлениях или обнаруживать незваное вражеское вооружение на нейтральной территории. Идея, лежащая в основе проекта XAI, заключается в том, что нейронные сети должны не только предоставлять недвусмысленные выходные данные, но также обосновывать свои действия (часть вычислительного контекста для конечного выхода). Например, если распознана фигура врага («это изображение солдата с оружием»), система должна объяснить, почему она таким образом его идентифицировала, т. е. в соответствии с какими характеристиками. Схожие системы также могут применяться для мониторинга электронной почты, призванного обнаружить переписку потенциальных террористов, предателей и двойных агентов. Система попытается не только обнаружить аномалии поведения, возникающие на фоне приемлемых социальных паттернов, но также объяснить, какой контекст элементов позволяет идентифицировать некую личность в качестве подозреваемого. Поскольку автоматизация обнаружения таких аномалий уже повлекла за собой жертвы (см. случай Skynet в Пакистане) [Pasquinelli 2017], очевидно, что работа проекта XAI также будет ориентирована на предотвращение алгоритмических катастроф в сфере базирующегося на предсказаниях управления (predictive policing).

Объяснимый искусственный интеллект (более точный термин — «объяснимое глубокое обучение») добавляет дополнительную петлю контроля к архитектуре нейронных сетей и подготавливает почву для нового поколения эпистемических медиаторов. В бизнес-сфере данные разработки пробуждают интерес, подкрепленный многомиллиардными вложениями, поскольку, например, страховые компании смогут ограничить свои выплаты только в отношении тех самоуправляемых машин, в которых будет находиться «вычислительный черный ящик» не только с функциями видео- и аудиозаписи, но и со способностью объяснить те или иные решения в поездке (представьте себе первую аварию между двумя самоуправляемыми транспортными средствами). Нечеловеческие масштабы вычислений и эстетика нового темного века уже нашли своих юридических представителей.

Заключение

Чтобы понять историческое значение искусственного интеллекта, этот текст подчеркивает, что на сегодняшний день главенствующей и доминирующей парадигмой является не символическая парадигма (GOFAI), а коннективистская, то есть нейронные сети, которые также являются основанием для систем глубинного обучения. То, как популярные медиа обращаются с искусственным интеллектом, — это фольклорный способ ссылаться на нейронные сети, предназначенные для распознавания паттернов (конкретная задача — создать более широкое определение интеллекта, конечно, не исчерпывающее). Распознавание паттернов возможно благодаря исчислениям внутреннего состояния нейронных сетей, которые включают в себя логическую форму статистической индукции. «Интеллект» нейронных сетей, следовательно, представляет собой лишь статистический вывод корреляций в тренировочном массиве данных. Ограничения, свойственные статистической индукции, могут быть обнаружены на примере переобучения или апофении, следствия которых постепенно дают о себе знать в коллективном восприятии и управлении. Несвойственные статистической индукции ограничения могут быть продемонстрированы благодаря пирсовской триаде индукции, дедукции и абдукции (гипотезы). Предполагается, что статистическая индукция приближается к форме слабой абдукции (например, в случае медицинского диагноза), но не способна автоматизировать сильную абдукцию, необходимую для открытия научных законов или изобретения лингвистических метафор. Причиной этому является то, что нейронные сети не могут избежать категориальных ограничений, имплицитно включенных в тренировочный массив данных. Нейронные сети показывают относительную степень автономности в своих вычислениях, однако человеческий фактор все еще важен для их работы. Сети являются компонентами в системе, над которой властвует человек. Они точно не проявляют признаки «автономного интеллекта» или сознания. Над-человеческие масштабы знания возникают только в совместной работе с надзирающим человеком, что подсказывает нам — «дополненный интеллект» был бы более точным термином, нежели «искусственный интеллект».

Статистические выводы, сделанные с помощью нейронных сетей, дали возможность вычислительному капитализму имитировать и автоматизировать как неквалифицированный, так и требующий специфических навыков труд[12]. Никто не ожидал, что даже водитель автобуса может стать источником когнитивного труда, который автоматизируется нейронными сетями в самоуправляемых транспортных средствах. Автоматизация интеллекта посредством статистического заключения — это новшество, которое капитал стремится применить на глобальном рынке труда, в логистике и рынках с неизведанными эффектами абнормализации, то есть искажением коллективного восприятия и социальных репрезентаций, в частности в алгоритмическом усилении классовых, расовых, гендерных предубеждений [Pasquinelli 2016]. Статистический вывод — это новый, искажающий инструмент Господина капитала[13].

Пер. с англ. Глеба Голубкова и Петра Строкина

Библиография / References

[Бейтсон 2000] — Бейтсон Г. Экология разума: Избранные статьи по антропологии, психиатрии и эпистемологии / Пер. с англ. Д.Я. Федотова, М.П. Папуша. М.: Смысл, 2000.

(Bateson G. Steps to an Ecology of Mind. Moscow, 2000. — In Russ.)

[Винер 1958] — Винер Н. Кибернетика, или Управление и связь в животном и машине / Пер. с англ. И.В. Соловьева. М.: Советское радио, 1958.

(Wiener N. Cybernetics: or Control and Communication in the Animal and the Machine. Moscow, 1958. — In Russ.)

[Вирильо 2004] — Вирильо П. Машина зрения / Пер. с фр. А.В. Шестакова. СПб.: Наука, 2004.

(Virilio P. La Machine de vision. Saint Petersburg, 2004. — In Russ.)

[Лакан 1999] — Лакан Ж. Семинары. Книга 2: «Я» в теории Фрейда и в технике психоанализа (1954/55) / Пер. с фр. А. Черноглазова. М.: Гнозис, 1999.

(Lacan J. Le séminaire. Livre II. Le moi dans la théorie de Freud et dans la technique de la psychanalyse. Moscow, 1999. — In Russ.)

[Маккалок, Питтс 1956] — Маккалок У., Питтс У. Логическое исчисление идей, относящихся к нервной активности // Автоматы: Сборник статей / Пер. с англ. Ю.Т. Медведева. М.: Издательство иностранной литературы, 1956. С. 362—384.

(Mcculoch W., Pitts W. A Logical Calculus of the Idea Immanent in Nervous Activity. Moscow, 1956. P. 362—384. — In Russ.)

[Маркс 1952] — Маркс К. Капитал: критика политической экономии. Том первый, книга 1: процесс производства капитала / Пер. с нем. И.И. Степанова-Скворцова. М.: Государственное издательство политической литературы, 1952.

(Marx K. Das Kapital. Erster Band. Buch I: Der Produktionsprocess des Kapitals. Moscow, 1952. — In Russ.)

[Николис, Пригожин 1979] — Николис Г., Пригожин И. Самоорганизация в неравновесных системах: от диссипативных структур к упорядоченности через флуктуации / Пер. с англ. В.Ф. Пастушенко. М.: Мир, 1979.

(Nicolis G., Prigogine I. Self-Organization in Non-Equilibrium Systems. Moscow, 1979. — In Russ.)

[Пирс 2000] — Пирс Ч.С. Некоторые последствия четырех неспособностей // Избранные философские произведения / Пер. Т. Дмитриева. М.: Логос, 2000. С. 48—95.

(Peirce C.S. Some Consequences of Four Incapabilities. Moscow, 2000. — In Russ.)

[Розенблатт 1965] — Розенблатт Ф. Принципы нейродинамики: перцептроны и теория механизмов мозга / Пер. с англ. В.Я. Алтаева, Б.А. Власюкова, Ю.А. Крутикова, Ю.А. Патругина. М.: Мир, 1965.

(Rosenblatt F. Principles of Neurodynamics: Perceptrons and the Theory of Brain. Moscow, 1965. — In Russ.)

[Шэннон 1963] — Шэннон К. Математическая теория связи // Работа по теории информации и кибернетике / Пер. с англ. С. Карпова. М.: Издательство иностранной литературы, 1963. С. 243—332.

(Shannon C. A Mathematical Theory of Communication. Moscow, 1948. P. 243—332. — In Russ.)

[Alpaydın 2014] — Alpaydın E. Introduction to Machine Learning. Cambridge, MA: MIT Press, 2014.

[Domingos 2015] — Domingos P. The Master Algorithm. New York: Basic Books, 2015.

[Eco 1986] — Eco U. Semiotics and the Philosophy of Language. Bloomington: Indiana University Press, 1986.

[Heylighen, Joslyn 2001] — Heylighen F., Joslyn C. Cybernetics and Second-Order Cybernetics // Encyclopedia of Physical Science and Technology 19 / Ed. by R.A. Meyers. New York: Academic Press, 2001.

[Link 2010] — Link D. Scrambling T-R-U-T-H: Rotating Letters as a Material Form of Thought // Variantology 4. On Deep Time Relations of Arts, Sciences and Technologies in the Arabic—Islamic World / Ed. by S. Zielinski, E. Fürlus. Cologne: König, 2010. P. 215—266.

[Magnani 2009] — Magnani L. Automatic Abductive Scientists // Magnani L. Abductive Cognition. Berlin; Heidelberg: Springer Science & Business Media, 2009. P. 112—115.

[McCulloch, Pitts 1947] — McCulloch W., Pitts W. How We Know Universals the Perception of Auditory and Visual Forms // Bulletin of Mathematical Biophysics. 1947. Vol. 9. № 3. P. 127—147.

[Minsky 1954] — Minsky M. Theory of Neural-Analog Reinforcement Systems and Its Application to the Brain Model Problem / Dissertation. Princeton University, 1954.

[Pasquinelli 2016] — Pasquinelli M. Abnormal Encephalization in the Age of Machine Learning // e-flux. 2016. № 75.

[Pasquinelli 2017] — Pasquinelli M. Arcana Mathematica Imperii: The Evolution of Western Computational Norms // Former West / Ed. by Hlavajova M. et al. Cambridge, MA: MIT Press, 2017. P. 281—293.

[Peirce 1965] — Peirce C.S. The Three Kinds of Goodness // Collected Papers. Vol 5. Cambridge, MA: Belknap, 1965. P. 145.

[Rosenblatt 1957] — Rosenblatt F. The Perceptron a Perceiving and Recognizing Automaton // Technical Report. 1957. № 85/460/1. P. 1—2.

[Rosenblatt 1960] — Rosenblatt R. Mark I Perceptron Operators’ Manual. Buffalo, N.Y.: Cornell Aeronautical Laboratory, 1960.

[Rumelhart, PDP Research Group 1986] — Rumelhart D., PDP Research Group. Parallel Distributed Processing: Explorations in the Microstructure of Cognition 1-2. Cambridge; MA: MIT Press, 1986.

[1] Перевод с английского выполнен по изданию: Pasquinelli M. Machines that Morph Logic: Neural Network and the Distorted Automation of Intelligence as Statistical Inference // Glass Bead journal. 2017. № 1. Публикуется с любезного разрешения автора.

[2] Так случилось, что формулировка Винера также повлияла на проведенную в 1955 году лекцию Жака Лакана, посвященную кибернетике и психоанализу, в которой логические вентили буквально рассматриваются как «двери», открывающие или закрывающие новые предзнаменования в рамках символического порядка [Лакан 1999].

[3] Общий искусственный интеллект (Artificial General Intelligence, AGI) зачастую представлен как попытка примирения дедуктивного (символического) подхода и статистического индуктивного (коннективистского). Все же на данный момент лишь коннективистская модель нейронных сетей была успешно автоматизирована, что бросает тень сомнения на метафизические и централизующие предпосылки общего искусственного интеллекта.

[4] Знаменательно, что книга Поля Вирильо, посвященная машинному зрению, также была вдохновлена перцептроном, хотя сам Вирильо не мог предвидеть, что перцептрон окажется доминирующей парадигмой машинного интеллекта в начале XXI века. См.: [Вирильо 2004].

[5] К настоящему времени нейронные сети продолжают развиваться в сторону более сложных топологий, учредив действительное вычислительное ars combinatoria (в частности, обратите внимание на автоэнкодеры, машину Больцмана, рекуррентную сеть с долгой краткосрочной памятью (LSTM-сеть), генеративно-состязательные сети и т. д.).

Нейронные сети являются наиболее проработанными и изощренными машинами в традиции вычисляемого знания, к которой также можно причислить арабское приспособление Заирджа, а также книгу Раймунда Луллия «Ars Magna» (1305). См.: [Link 2010].

[6] Это лишь частный случай, представленный в целях демонстрации. Функции активации могут осуществляться и по-другому.

[7] Касательно попыток автоматизировать слабую абдукцию см.: [Magnani 2009]

[8] Термин «онтология» здесь используется в смысле информатики.

[9] См.: Word2vec: инструмент, позволяющий выстраивать отображения слов в векторном пространстве.

[10] Это касается обучения как с учителем, так и без него. Я благодарю Анила Бава-Кавиа за прояснение этого момента.

[11] См.: http://www.darpa.mil/program/explainable-artificial-intelligence.

[12] Несмотря на множество различных подходов к машинному интеллекту, гегемония коннективизма все же в вопросе автоматизации дает о себе знать. Доступное изложение различных семей машинного обучения можно найти в: [Domingos 2015].

[13] «Частичное искусство отдельного машинного рабочего, подвергшегося опустошению, исчезает как ничтожная и не имеющая никакого значения деталь перед наукой, перед колоссальными силами природы и перед общественным массовым трудом, воплощенными в системе машин и создающими вместе с последней власть “хозяина” (master)» [Маркс 1952: 429].